- лЎңм•„ л””нҠёк°Җ 4кҙҖм—җм„ң л§һл”ң н–ҲлӢӨкі мӨ‘лӢЁл°•лҠ” кіөлҢҖмһҘ [622]

- л©”мқҙн”Ң мһҗмӮҙн•ң кі л”© л§Ңк°Өлҹ¬ [203]

- лЎңм•„ к°ӨнҺҢ) л°ёлҹ°мҠӨнҶ лЎ нҳ„мӢӨ г…Ӣг…Ӣг…Ӣг…Ӣ к°ңмӣғкё°л„Ө [165]

- м°ЁлІӨ [5мӣ” мә нҺҳмқё] лӮҳл“Өмқҙ мқёмҰқн•ҳл©ҙ, 2000мқҙлӢҲ+мЈјмң н• мқёк¶Ң! [32]

- кұёк·ёлЈ№ к°•кі м–‘мқҙ лүҙ진мҠӨ н•ҙлҰ° [5]

IT мғҲмҶҢмӢқ

м „мІҙліҙкё°

лӘЁл°”мқј мғҒлӢЁ л©”лүҙ

ліёл¬ё нҺҳмқҙм§Җ

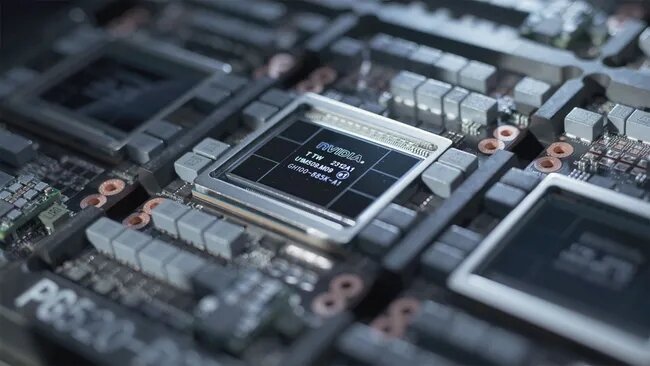

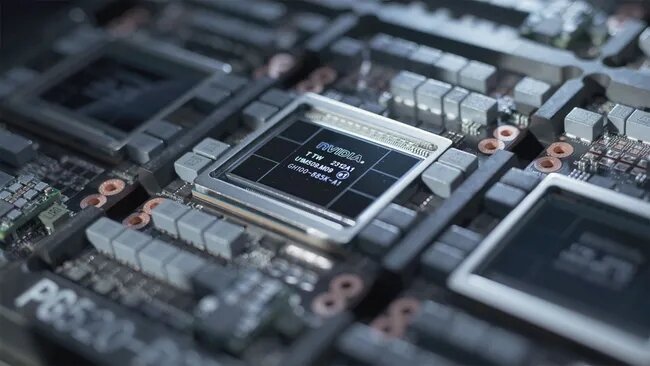

[л°ңн‘ң] Elon MuskлҠ” м°Ём„ёлҢҖ Grok 3 лӘЁлҚёмқ„ нӣҲл Ён•ҳл Өл©ҙ 100,000к°ңмқҳ Nvidia H100 GPUк°Җ н•„мҡ”н• кІғмқҙлқјкі л§җн–ҲмҠөлӢҲлӢӨ.

мЎ°нҡҢ: 57

2024-04-17 18:09:57

кё°мӮ¬ мӣҗл¬ё -В https://www.tomshardware.com/tech-industry/artificial-intelligence/elon-musk-says-the-next-generation-grok-3-model-will-require-100000-nvidia-h100-gpus-to-train

гҖҖ В В

В В

гҖҖ

В В

В В н…ҢмҠ¬лқјмқҳ CEOмқҙмһҗ xAIмқҳ м°ҪлҰҪмһҗмқё мқјлЎ лЁёмҠӨнҒ¬лҠ” мқјл°ҳ мқёкіөм§ҖлҠҘ(AGI)мқҳ л°ңм „м—җ лҢҖн•ҙ кіјк°җн•ң мҳҲмёЎмқ„ лӮҙлҶ“кі AI мӮ°м—…мқҙ м§Ғл©ҙн•ң кіјм ңм—җ лҢҖн•ҙ л…јмқҳн–ҲмҠөлӢҲлӢӨ. к·ёлҠ” AGIк°Җ мқҙлҘҙл©ҙ лӮҙл…„мқҙлӮҳ 2026л…„м—җ мқёк°„ м§ҖлҠҘмқ„ лҠҘк°Җн• мҲҳ мһҲм§Җл§Ң мқҙлҘј нӣҲл Ён•ҳл Өл©ҙ м—„мІӯлӮң мҲҳмқҳ н”„лЎңм„ём„ңк°Җ н•„мҡ”н•ҳкі кІ°кіјм ҒмңјлЎң м—„мІӯлӮң м–‘мқҳ м „л Ҙмқҙ н•„мҡ”н• кІғмқҙлқјкі В лЎңмқҙн„° нҶөмӢ мқҖ ліҙлҸ„н–ҲмҠөлӢҲлӢӨ .

Muskмқҳ лІӨмІҳмқё xAIлҠ” нҳ„мһ¬ Grok лҢҖк·ңлӘЁ м–ём–ҙ лӘЁл“ңмқҳ л‘җ лІҲм§ё лІ„м „мқ„ көҗмңЎн•ҳкі мһҲмңјл©° 5мӣ”к№Ңм§Җ лӢӨмқҢ көҗмңЎ лӢЁкі„лҘј мҷ„лЈҢн• кІғмңјлЎң мҳҲмғҒлҗ©лӢҲлӢӨ. Grok лІ„м „ 2 лӘЁлҚёмқҳ нӣҲл Ём—җлҠ” мөңлҢҖ 20,000к°ңмқҳ Nvidia H100 GPUк°Җ н•„мҡ”н–Ҳмңјл©°, MuskлҠ” н–Ҙнӣ„ л°ҳліөм—җм„ңлҠ” нӣЁм”¬ лҚ” л§ҺмқҖ лҰ¬мҶҢмҠӨк°Җ н•„мҡ”н• кІғмңјлЎң мҳҲмғҒн•ҳкі мһҲмңјл©°, Grok 3 лӘЁлҚёмқҳ нӣҲл Ём—җлҠ” м•Ҫ 100,000к°ңмқҳ Nvidia H100 칩мқҙ н•„мҡ”н•©лӢҲлӢӨ.

Muskм—җ л”°лҘҙл©ҙ AI кё°мҲ мқҳ л°ңм „мқҖ нҳ„мһ¬ л‘җ к°Җм§Җ мЈјмҡ” мҡ”мқё, мҰү Nvidiaмқҳ H100кіј к°ҷмқҖ кі кёү н”„лЎңм„ём„ңмқҳ кіөкёү л¶ҖмЎұ(100,000к°ңлҘј л№ЁлҰ¬ нҷ•ліҙн•ҳкё°к°Җ мүҪм§Җ м•ҠмқҢ)кіј м „кё° к°Җмҡ©м„ұмңјлЎң мқён•ҙ л°©н•ҙлҘј л°ӣкі мһҲмҠөлӢҲлӢӨ.

Nvidiaмқҳ H100 GPUлҠ” мҷ„м „нһҲ нҷңмҡ©лҗ л•Ң м•Ҫ 700WлҘј мҶҢ비н•ҳлҜҖлЎң AI л°Ҹ HPC мӣҢнҒ¬лЎңл“ңмҡ© GPU 100,000к°ңлҠ” л¬ҙл Ө 70MWмқҳ м „л Ҙмқ„ мҶҢл№„н• мҲҳ мһҲмҠөлӢҲлӢӨ. мқҙлҹ¬н•ң GPUк°Җ мһ‘лҸҷн•ҳл Өл©ҙ м„ңлІ„мҷҖ лғүк°Ғмқҙ н•„мҡ”н•ҳлҜҖлЎң 100,000к°ңмқҳ Nvidia H100 н”„лЎңм„ём„ңлҘј к°–м¶ҳ лҚ°мқҙн„° м„јн„°лҠ” м•Ҫ 100л©”к°ҖмҷҖнҠёмқҳ м „л Ҙмқ„ мҶҢ비н•ңлӢӨкі н•ҙлҸ„ л¬ҙл°©н•©лӢҲлӢӨ. мқҙлҠ” мһ‘мқҖ лҸ„мӢңмқҳ м „л Ҙ мҶҢ비лҹүкіј 비мҠ·н•©лӢҲлӢӨ.

лЁёмҠӨнҒ¬лҠ” м§ҖкёҲк№Ңм§Җ м»ҙн“ЁнҢ… GPU кіөкёүмқҙ мӢ¬к°Ғн•ң мһҘм• л¬јмқҙм—Ҳм§Җл§Ң м•һмңјлЎң 1~2л…„ м•Ҳм—җ м „л Ҙ кіөкёүмқҙ м җм җ лҚ” мӨ‘мҡ”н•ҙм§Ҳ кІғмқҙлқјкі к°•мЎ°н–ҲмҠөлӢҲлӢӨ. мқҙлҹ¬н•ң мқҙмӨ‘ м ңм•ҪмқҖ мҰқк°Җн•ҳлҠ” кі„мӮ° мҡ”кө¬ мӮ¬н•ӯмқ„ 충мЎұн•ҳкё° мң„н•ҙ AI кё°мҲ мқ„ нҷ•мһҘн•ҳлҠ” кіјм ңлҘј к°•мЎ°н•©лӢҲлӢӨ.

мқҙлҹ¬н•ң м–ҙл ӨмӣҖм—җлҸ„ л¶Ҳкө¬н•ҳкі м»ҙн“ЁнҢ… л°Ҹ л©”лӘЁлҰ¬ м•„нӮӨн…ҚмІҳмқҳ л°ңм „мңјлЎң мқён•ҙ н–Ҙнӣ„ лӘҮ л…„ лҸҷм•Ҳ м җм җ лҚ” нҒ° к·ңлӘЁмқҳ LLM(лҢҖнҳ• м–ём–ҙ лӘЁлҚё) көҗмңЎмқҙ к°ҖлҠҘн•ҙм§Ҳ кІғмһ…лӢҲлӢӨ. NvidiaлҠ” GTC 2024м—җм„ң мҲҳмЎ° к°ңмқҳ л§Өк°ңліҖмҲҳлҘј мӮ¬мҡ©н•ҳм—¬ LLMмңјлЎң нҷ•мһҘн•ҳлҸ„лЎқ м„Өкі„лҗң GPU м•„нӮӨн…ҚмІҳ л°Ҹ н”Ңлһ«нҸјмқё Blackwell B200мқ„ кіөк°ңн–ҲмҠөлӢҲлӢӨ . мқҙлҠ” AGI к°ңл°ңм—җ мӨ‘мҡ”н•ң м—ӯн• мқ„ н• кІғмһ…лӢҲлӢӨ.

мӢӨм ңлЎң лЁёмҠӨнҒ¬лҠ” м•һмңјлЎң 1~2л…„ м•Ҳм—җ к°ҖмһҘ лҳ‘лҳ‘н•ң мқёк°„ліҙлӢӨ лҚ” лҳ‘лҳ‘н•ң мқёкіөм§ҖлҠҘмқҙ л“ұмһҘн• кІғмқҙлқјкі лҜҝкі мһҲмҠөлӢҲлӢӨ. лЁёмҠӨнҒ¬лҠ” X мҠӨнҺҳмқҙмҠӨмҷҖмқҳ мқён„°л·°м—җм„ң "AGIлҘј к°ҖмһҘ лҳ‘лҳ‘н•ң мқёк°„ліҙлӢӨ лҚ” лҳ‘лҳ‘н•ң кІғмңјлЎң м •мқҳн•ңлӢӨл©ҙ м•„л§ҲлҸ„ лӮҙл…„, 2л…„ лӮҙк°Җ лҗ кІғ"мқҙлқјкі л§җн–ҲлӢӨ. мқҙлҠ” мқҙм ң н„°лҜёл„Өмқҙн„°лҘј лӢӨмӢң ліҙлҹ¬ к°Ҳ л•Ңк°Җ лҗң кІғ к°ҷкі лҜёлһҳмқҳ AGI лҢҖкө°мЈјк°Җ мҠӨм№ҙмқҙл„·ліҙлӢӨ лҚ” нӣҢлҘӯн•ҙм§Җкё°лҘј л°”лһҚлӢҲлӢӨ.

м•„лһҳ URLмқ„ м „мІҙм„ нғқн•ҳкі ліөмӮ¬н•ҳм„ёмҡ”.

Bector

Bector

лӘЁл°”мқј кІҢмӢңнҢҗ н•ҳлӢЁлІ„нҠј

лӘЁл°”мқј кІҢмӢңнҢҗ н•ҳлӢЁлІ„нҠј

м§ҖкёҲ лңЁлҠ” мқёлІӨ

лҚ”ліҙкё°+лӘЁл°”мқј кІҢмӢңнҢҗ лҰ¬мҠӨнҠё

-

0 лҢ“кёҖл°ңн‘ң OpenAI, м•„мӢңм•„ мөңмҙҲ мӮ¬л¬ҙмӢӨлЎң лҸ„мҝ„ м„ нғқ

Bector

Lv.65

мЎ°нҡҢ 85

04-17

Bector

Lv.65

мЎ°нҡҢ 85

04-17

-

0 лҢ“кёҖл°ңн‘ң мҳҒкөӯкіј н•ңкөӯмқҙ AI м„ңмҡё м„ңл°Ӣмқ„ кіөлҸҷ к°ңмөңн•ңлӢӨ

Bector

Lv.65

мЎ°нҡҢ 56

04-17

Bector

Lv.65

мЎ°нҡҢ 56

04-17

-

0 лҢ“кёҖл°ңн‘ң Microsoft AI, 'м—„мІӯлӮң мқёмһ¬ н’Җ'м—җ м ‘к·јн•ҳкё° мң„н•ҙ лҹ°лҚҳ н—ҲлёҢ к°ңм„Ө

Bector

Lv.65

мЎ°нҡҢ 48

04-17

Bector

Lv.65

мЎ°нҡҢ 48

04-17

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ GenAI мӢңлҢҖмқҳ л§ҲмјҖнҢ…м—җ лҚ°мқҙн„° н’Ҳм§Ҳмқҙ мӨ‘мҡ”н•ң мқҙмң

Bector

Lv.65

мЎ°нҡҢ 53

04-17

Bector

Lv.65

мЎ°нҡҢ 53

04-17

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ AIк°Җ мғқм„ұн•ң л”ҘнҺҳмқҙнҒ¬лЎңл¶Җн„° 비мҰҲлӢҲмҠӨлҘј ліҙнҳён•ҳлҠ” л°©лІ•

Bector

Lv.65

мЎ°нҡҢ 62

04-17

Bector

Lv.65

мЎ°нҡҢ 62

04-17

-

0 лҢ“кёҖл°ңн‘ң Nvidiaмқҳ H100 AI GPU л¶ҖмЎұ нҳ„мғҒмқҖ лҰ¬л“ң нғҖмһ„мқҙ мөңлҢҖ 4к°ңмӣ”м—җм„ң 8~12мЈјлЎң лӢЁм¶•лҗЁм—җ л”°лқј мҷ„нҷ”лҗ©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 58

04-17

Bector

Lv.65

мЎ°нҡҢ 58

04-17

-

0 лҢ“кёҖл°ңн‘ң Elon MuskлҠ” м°Ём„ёлҢҖ Grok 3 лӘЁлҚёмқ„ нӣҲл Ён•ҳл Өл©ҙ 100,000к°ңмқҳ Nvidia H100 GPUк°Җ н•„мҡ”н• кІғмқҙлқјкі л§җн–ҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 58

04-17

Bector

Lv.65

мЎ°нҡҢ 58

04-17

-

0 лҢ“кёҖл°ңн‘ң Street Fighter IIIм—җм„ңлҠ” 14лӘ…мқҳ LLMмқҙ лҢҖкІ°н•©лӢҲлӢӨ. AI лҢҖкІ°м—җм„ңлҠ” м–ҙл–Ө лӘЁлҚёмқҙ мөңкі мқҳ мҠӨнҠёлҰ¬нҠё нҢҢмқҙн„°мқём§Җ м•Ңм•„лғ…лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 53

04-17

Bector

Lv.65

мЎ°нҡҢ 53

04-17

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ Arm ChinaлҠ” AMD, Intel л°Ҹ Appleкіј кІҪмҹҒн•ҳкё° мң„н•ҙ мҳӨн”Ҳ мҶҢмҠӨ л“ңлқјмқҙлІ„лЎң AI к°ҖмҶҚкё°лҘј к°•нҷ”н•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 166

04-01

Bector

Lv.65

мЎ°нҡҢ 166

04-01

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ LenovoлҠ” AMDмқҳ Instinct MI300м—җ лҢҖн•ң мҲҳмҡ”к°Җ мӮ¬мғҒ мөңкі лқјкі л°қнҳ”мҠөлӢҲлӢӨ. лӘЁл“ мЈјмҡ” н•ҳл“ңмӣЁм–ҙ кіөкёүм—…мІҙмқҳ AI мҶ”лЈЁм…ҳмқ„ м ңкіөн• кі„нҡҚмһ…лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 157

04-01

Bector

Lv.65

мЎ°нҡҢ 157

04-01

-

0 лҢ“кёҖл°ңн‘ң BroadcomмқҖ кұ°лҢҖн•ң AI 칩мқ„ м„ ліҙмҳҖмҠөлӢҲлӢӨ. XPUлҠ” мҶҢ비мһҗ AI нҡҢмӮ¬лҘј мң„н•ҙ м ңмһ‘лҗң м„ёкі„ мөңлҢҖ 칩мқҙ лҗ мҲҳ мһҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 143

04-01

Bector

Lv.65

мЎ°нҡҢ 143

04-01

-

0 лҢ“кёҖл°ңн‘ң RTX лҒ„кі AI мјңкё°: JensenмқҖ 5~10л…„ м•Ҳм—җ мҷ„м „н•ң AI мғқм„ұ кІҢмһ„мқ„ ліҙкІҢ лҗ кІғмқҙлқјкі л§җн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 255

04-01

Bector

Lv.65

мЎ°нҡҢ 255

04-01

-

0 лҢ“кёҖл°ңн‘ң мӮјм„ұ, 엔비디아 л“ұм—җ лҸ„м „н•ҳкё° мң„н•ҙ AI 칩 м¶ңмӢң - 'л§Ҳн•ҳ 1' 칩 2025л…„ мҙҲ м¶ңмӢң мҳҲм •

Bector

Lv.65

мЎ°нҡҢ 158

04-01

Bector

Lv.65

мЎ°нҡҢ 158

04-01

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ AI мҠӨнғҖнҠём—… ExtropicмқҖ GPU, CPU, TPUлҘј лҠҘк°Җн• кІғмқҙлқјкі лҢҖлӢҙн•ҳкІҢ мЈјмһҘн•ҳлҠ” мҙҲм „лҸ„ н”„лЎңм„ём„ңлЎң мҠӨн…”мҠӨм—җм„ң лІ—м–ҙлӮ¬мҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 132

04-01

Bector

Lv.65

мЎ°нҡҢ 132

04-01

-

0 лҢ“кёҖл°ңн‘ң NASAмқҳ мҳӨлһҳлҗң мҠҲнҚјм»ҙн“Ён„°лЎң мқён•ҙ мһ„л¬ҙ м§Җм—°мқҙ л°ңмғқн•ҳкі мһҲмҠөлӢҲлӢӨ. н•ҳлӮҳлҠ” CPUк°Җ 18,000к°ңмқёлҚ° GPUк°Җ 48к°ңм—җ л¶Ҳкіјн•ҙ м—…лҚ°мқҙнҠёк°Җ м ҲмӢӨнһҲ н•„мҡ”н•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 177

03-19

Bector

Lv.65

мЎ°нҡҢ 177

03-19

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ OpenAIлҠ” мһҗмІҙ AI н”„лЎңм„ём„ңлҘј л§Ңл“ңлҠ” кІғмқ„ лӘ©н‘ңлЎң н•ҳкі мһҲмҠөлӢҲлӢӨ. м•„л¶ҖлӢӨ비 нҲ¬мһҗ нҡҢмӮ¬мҷҖ нҳ‘мғҒ мӨ‘мқё 칩 лІӨмІҳ: ліҙкі м„ң

Bector

Lv.65

мЎ°нҡҢ 174

03-19

Bector

Lv.65

мЎ°нҡҢ 174

03-19

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ Jensen HuangмқҖ кІҪмҹҒмӮ¬мқҳ л¬ҙлЈҢ AI 칩조차лҸ„ Nvidiaмқҳ GPUлҘј мқҙкёё мҲҳ м—ҶлӢӨкі л§җн–ҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 231

03-19

Bector

Lv.65

мЎ°нҡҢ 231

03-19

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ Elon Muskмқҳ xAI мҳӨн”ҲмҶҢмҠӨ Grok

Bector

Lv.65

мЎ°нҡҢ 234

03-19

Bector

Lv.65

мЎ°нҡҢ 234

03-19

-

0 лҢ“кёҖл°ңн‘ң [кё°нғҖ] UAE, OpenAIмқҳ мһҗмІҙ 칩м—җ мһҗкёҲ м§Җмӣҗ мҳҲм •

Bector

Lv.65

мЎ°нҡҢ 271

03-19

Bector

Lv.65

мЎ°нҡҢ 271

03-19

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ AnthropicмқҖ Claude 3 Haikuк°Җ лҸҷкёү лӘЁлҚё мӨ‘ к°ҖмһҘ л№ лҘё лӘЁлҚёмқҙлқјкі л§җн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 233

03-19

Bector

Lv.65

мЎ°нҡҢ 233

03-19

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ EU, м—Үк°ҲлҰ° л°ҳмқ‘м—җ лҢҖн•ҙ л…јлһҖмқҳ м—¬м§Җк°Җ мһҲлҠ” AI лІ•м•Ҳ мҠ№мқё

Bector

Lv.65

мЎ°нҡҢ 161

03-19

Bector

Lv.65

мЎ°нҡҢ 161

03-19

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ н•ңкөӯ м—°кө¬мһҗл“ӨмқҖ мғҲлЎңмҡҙ мӢ кІҪ AI 칩мңјлЎң NvidiaлҘј л¶ҖлҒ„лҹҪкІҢ л§Ңл“Өм—ҲмҠөлӢҲлӢӨ. м „л Ҙ мҶҢлӘЁлҹүмқҙ 625л°° м Ғкі , 41л°° лҚ” мһ‘лӢӨкі мЈјмһҘн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 329

03-12

Bector

Lv.65

мЎ°нҡҢ 329

03-12

-

0 лҢ“кёҖл°ңн‘ң AMDлҠ” Nvidiaм—җ л°ҳкІ©н•ҳкі Radeon л°Ҹ Ryzenм—җм„ң лЎң컬 AI мұ—лҙҮмқ„ мӢӨн–үн•ҳлҠ” л°©лІ•мқ„ мһҗм„ёнһҲ м„ӨлӘ…н•©лӢҲлӢӨ. нғҖмӮ¬ м•ұ мӮ¬мҡ©мқ„ к¶ҢмһҘн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 214

03-12

Bector

Lv.65

мЎ°нҡҢ 214

03-12

-

0 лҢ“кёҖкё°нғҖ AMDлҠ” кІҢмһ„мҡ© AI м—…мҠӨмјҖмқјлҹ¬лҘј к°ңл°ң мӨ‘мһ„мқ„ нҷ•мқён–ҲмҠөлӢҲлӢӨ. CTO PapermasterлҠ” мқҙкІғмқҙ 'м „мІҙ нҸ¬нҠёнҸҙлҰ¬мҳӨлҘј нҷңм„ұнҷ”н•ҳлҠ” AI'мқҳ мқјл¶Җлқјкі л§җн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 197

03-12

Bector

Lv.65

мЎ°нҡҢ 197

03-12

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ AI мғқм„ұ мҪҳн…җмё л°Ҹ кё°нғҖ л¶ҲлҰ¬н•ң кҙҖн–үмңјлЎң мқён•ҙ мҳӨлһ«лҸҷм•Ҳ мЈјмҡ” CNETмқҙ Wikipediaмқҳ лё”лһҷлҰ¬мҠӨнҠё мҶҢмҠӨм—җ нҸ¬н•Ёлҗҳм—ҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 192

03-12

Bector

Lv.65

мЎ°нҡҢ 192

03-12

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ IBMмқҳ мғҲлЎңмҡҙ AI м§Җмӣҗ SSDлҠ” 1분 мқҙлӮҙм—җ лһң섬мӣЁм–ҙлҘј мӢқлі„н•ҳкі к·јм Ҳн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 236

02-29

Bector

Lv.65

мЎ°нҡҢ 236

02-29

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ Jensen HuangмқҖ м•„мқҙл“Өмқҙ мҪ”л”©мқ„ л°°мҡ°л©ҙ м•Ҳ лҗҳл©°, AIм—җ л§ЎкІЁм•ј н•ңлӢӨкі л§җн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 261

02-29

Bector

Lv.65

мЎ°нҡҢ 261

02-29

-

0 лҢ“кёҖл°ңн‘ң Stability AI, Stable Diffusion 3 н…ҚмҠӨнҠё-мқҙлҜём§Җ лӘЁлҚё лҜёлҰ¬ліҙкё°

Bector

Lv.65

мЎ°нҡҢ 287

02-29

Bector

Lv.65

мЎ°нҡҢ 287

02-29

-

0 лҢ“кёҖл°ңн‘ң Mistral AI, LLMкіј кІҪмҹҒн•ҳлҠ” мЈјмҡ” н”Ңл Ҳмқҙм–ҙ кіөк°ң

Bector

Lv.65

мЎ°нҡҢ 253

02-29

Bector

Lv.65

мЎ°нҡҢ 253

02-29

-

0 лҢ“кёҖл°ңн‘ң Google, 'мӢӨн—ҳм Ғ' 1M нҶ нҒ° м»Ён…ҚмҠӨнҠёлЎң Gemini 1.5 м¶ңмӢң

Bector

Lv.65

мЎ°нҡҢ 287

02-19

Bector

Lv.65

мЎ°нҡҢ 287

02-19

-

0 лҢ“кёҖл°ңн‘ң AmazonмқҖ 'кёҙкёү лҠҘл Ҙ'мңјлЎң 980M л§Өк°ңліҖмҲҳ LLMмқ„ көҗмңЎн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 261

02-19

Bector

Lv.65

мЎ°нҡҢ 261

02-19

-

0 лҢ“кёҖм—…кі„лҸҷн–Ҙ OpenAIлҠ” мӮ¬мҡ©мһҗлҘј м„ нғқн•ҳкё° мң„н•ҙ ChatGPT л©”лӘЁлҰ¬лҘј м¶ңмӢңн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 237

02-19

Bector

Lv.65

мЎ°нҡҢ 237

02-19

-

0 лҢ“кёҖкё°нғҖ JumpCloud ліҙкі м„ңм—җ л”°лҘҙл©ҙ мӨ‘мҶҢкё°м—…мқҖ AIм—җ лҢҖн•ҙ к°Ҳл“ұмқ„ кІӘкі мһҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 241

02-19

Bector

Lv.65

мЎ°нҡҢ 241

02-19

-

0 лҢ“кёҖкё°нғҖ Fetch.aiмҷҖ Deutsche Telekomмқҙ AIмҷҖ лё”лЎқмІҙмқёмқ„ мңөн•©н•ҳкё° мң„н•ҙ нҢҢнҠёл„ҲмӢӯмқ„ л§әм—ҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 291

02-19

Bector

Lv.65

мЎ°нҡҢ 291

02-19

-

0 лҢ“кёҖкё°нғҖ нҶөмӢ м—…мІҙлҠ” 2028л…„к№Ңм§Җ AI л„ӨнҠёмӣҢнҒ¬ мЎ°м •м—җ 200м–ө лӢ¬лҹ¬лҘј м§Җм¶ңн• мҳҲм •мһ…лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 230

02-19

Bector

Lv.65

мЎ°нҡҢ 230

02-19

-

0 лҢ“кёҖл°ңн‘ң 분нҷҚмғү м—ҙ нҺҳмқҙмҠӨнҠёлҠ” л”ёкё° лғ„мғҲк°Җ лӮ©лӢҲлӢӨ. Extreme Mugurisu 4G Strawberry EditionмқҖ Thermal Grizzlyмқҳ KryonautмҷҖ кІҪмҹҒн•©лӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 444

02-05

Bector

Lv.65

мЎ°нҡҢ 444

02-05

-

0 лҢ“кёҖл°ңн‘ң PalitлҠ” Nvidiaмқҳ м ҖмҳҲмӮ° кІҢмһ„ GPUм—җ DVI нҸ¬нҠёлҘј лӢӨмӢң м ңкіөн•©лӢҲлӢӨ. RTX 3050 KalmXлҠ” нҢЁмӢңлёҢ мҝЁлҹ¬мҷҖ м ңлЎң м „мӣҗ м»Өл„Ҙн„°лҘј к°–м¶”кі мһҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 331

02-05

Bector

Lv.65

мЎ°нҡҢ 331

02-05

-

0 лҢ“кёҖл°ңн‘ң NvidiaлҠ” RTX 4080 Super Founders Editionмқҳ ліҙл“ң л””мһҗмқёмқ„ лӢЁмҲңнҷ”н–ҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 326

02-05

Bector

Lv.65

мЎ°нҡҢ 326

02-05

-

0 лҢ“кёҖл°ңн‘ң Intel Arc A370M лӘЁл°”мқј GPUлҠ” л°©м—ҙнҢҗкіј мһ‘мқҖ лғүк°Ғ нҢ¬мқҳ лҸ„мӣҖмңјлЎң лҚ°мҠӨнҒ¬нғ‘ м№ҙл“ңлЎң ліҖлӘЁн–ҲмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 282

02-05

Bector

Lv.65

мЎ°нҡҢ 282

02-05

-

0 лҢ“кёҖл°ңн‘ң мӮ¬м–‘, мӮ¬м§„, к°ҖкІ©мқ„ нҸ¬н•Ён•ҳм—¬ нҳ„мһ¬ лӮҳм—ҙлҗң лӘЁл“ Nvidia RTX 4080 Super м№ҙл“ңлҠ” лӢӨмқҢкіј к°ҷмҠөлӢҲлӢӨ.

Bector

Lv.65

мЎ°нҡҢ 249

02-05

Bector

Lv.65

мЎ°нҡҢ 249

02-05

лӘЁл°”мқј кІҢмӢңнҢҗ н•ҳлӢЁлІ„нҠј

лӘЁл°”мқј кІҢмӢңнҢҗ нҺҳмқҙ징

мөңк·ј HOTн•ң мҪҳн…җмё

- кІ¬м Ғ

- кІҢмһ„

- IT

- мң лЁё

- м—°мҳҲ

- 1мқҙлҘҷн• к№Ңмҡ”

- 2100л§Ңмӣҗ мқҙн•ҳ кІ¬м Ғ нҸүк°Җ л¶ҖнғҒл“ңл Өмҡ”

- 3мӮ¬л¬ҙмҡ© PC 50л§ҢмӣҗлҜёл§ҢмңјлЎң кІ¬м Ғ л¶ҖнғҒл“ңлҰҪлӢҲлӢӨ.

- 4м—¬мһҗмқёлҚ°.. мҳөм№ҳ лҸҢм•„к°ҖлҠ” м»ҙн“Ён„° мӮ¬л Өкі н•©лӢҲлӢӨ 100л§Ңмӣҗ

- 5100л§Ңмӣҗ лҢҖ кІ¬м Ғ мҡ”мІӯл“ңлҰҪлӢҲлӢӨ.

- 6кІ¬м Ғ нҷ•мқё л°Ҹ лӘЁлӢҲн„° нҳёнҷҳ л¶ҖнғҒл“ңлҰҪлӢҲлӢӨ.

- 7кІ¬м Ғ кө¬м„ұ нҷ•мқё л¶ҖнғҒл“ңлҰҪлӢҲлӢӨ.

- 8л°°к·ё н’Җмҳө мӮ¬м–‘ м Җл ҙн•ҳкІҢ кІ¬м ҒмўҖ лӮҙмЈјмӢӨмҲҳмһҲмқ„к№Ңмҡ”?

- 9кІҖмқҖмӮ¬л§үмҡ©мңјлЎң м»ҙн“Ён„° кІ¬м Ғм§ңлҙӨмҠөлӢҲлӢӨ. нҸүк°Җ л¶ҖнғҒл“ңлҰҪлӢҲлӢӨ!

- 10м»ҙн“Ён„° м—…кёҖ кІ¬м Ғ л°ӣм•„ліҙкі мӢ¶мҠөлӢҲлӢӨ

- 1лё”лҰ¬мҰҲм»Ё 2024, лҸҢм—° 'м·ЁмҶҢ'

- 2л¬ҙкІҖм—ҙ мҳҲкі 'мҠӨн…”лқј лё”л Ҳмқҙл“ң', м—…лҚ°мқҙнҠёлЎң к°ҖлҰ° л…ём¶ң

- 3'мҠӨн…”лқј лё”л Ҳмқҙл“ң', н•ҙмҷё л§ӨмІҙмқҳ нҸүк°ҖлҠ”?

- 4"лҸҢм•„мҷҖмҡ” мӢңмҰҢ4 н•ҳлҹ¬" WoW, 10мң„к¶Ң мһ¬м§„мһ… мҪ”м•һ

- 5мҠӨн…”лқј лё”л Ҳмқҙл“ң лҰ¬л·°

- 6мң лӢҲм„ён”„ нӣ„мӣҗ, 'нҺҳмқҙм»Ө' мқҙмғҒнҳҒкіј н•Ёк»ҳ

- 7л„ҘмҠЁ, н…ңл№Ё IP мһ¬н•ҙм„қн•ң 'н”„лЎңм қнҠёT' нҚјлё”лҰ¬мӢұн•ңлӢӨ

- 824мқј 20мӢң м•„мҠӨ лҢҖлҘҷмңјлЎң, 'м•„мҠӨлӢ¬ м—°лҢҖкё°' м¶ңмӢң

- 9мІ« мҪҳмҶ”кІҢмһ„! к№Җнҳ•нғң лҢҖн‘ң "к°ңл°ң진 лӘЁл‘җк°Җ мһҗлһ‘мҠӨлҹҪлӢӨ"

- 10л„ӨмқҙлІ„ м№ҳм§Җм§Ғ, 5мӣ” 2мқјл¶Җн„° 'к·ёлҰ¬л“ң' м Ғмҡ©

- 1м• н”Ң л№„м „ н”„лЎң мғқмӮ° мЎ°кё° мӨ‘лӢЁ, "мҲҳмҡ” м—ҶлӢӨ"

- 2мҙүк°Ғ л””л°”мқҙмҠӨ кё°м—… вҖҳ비햅нӢұмҠӨвҖҷ, л©”нғҖмҷҖ мҶҗмһЎм•ҳлӢӨ

- 3мӢӨмҶҚ мһҲлҠ” кІңнҠёл¶Ғмқ„ м°ҫкі мһҲлӢӨл©ҙ? AMD R7 8845HSлҘј мЈјлӘ©н•ҙ ліҙмһҗ

- 4лӢҢн…җлҸ„ мҠӨмң„м№ҳ2, мӮјм„ұкіј н•Ёк»ҳ?

- 5AMD лқјлқјлһңл“ң, нһҳмқ„ мҲЁкёҙ 진м§ңмқҳ мЎ°н•©

- 6AI PC мӢңмһҘлҸ„ мһҗмӢ мһҲлӢӨ! HP нҸ¬л¶Җк°Җ лӢҙкёҙ к°„лӢҙнҡҢ

- 7MSI, 0.5ms мқ‘лӢөмҶҚлҸ„! 27мқём№ҳ 4K вҖҳMAG 274URFWвҖҷ нҷ”мқҙнҠё м¶ңмӢң!

- 8кі§ мҳӨлҠ” лҢҖнҳ• м„ёмқј! л¬ҙмҠЁ кІҢмқҙл°Қ л…ёнҠёл¶Ғмқ„ мӮҙк№Ң?

- 9м—җмқҙмҲҳмҠӨ, AI кё°л°ҳ л…ёнҠёл¶Ғ вҖҳ비ліҙл¶Ғ(Vivobook) SвҖҷ мӢңлҰ¬мҰҲ м¶ңмӢң

- 10н•ңкөӯл Ҳл…ёлІ„, м”ҪнҒ¬нҢЁл“ң X1 м№ҙліё м¶ңмӢң кё°л…җ н”„лЎңлӘЁм…ҳ

- 1Mbcм¶ңмӢ мһҘмқёмҲҳкё°мһҗк№Җкұҙнқ¬ л””мҳ¬л°ұмқҖмһҠм–ҙлқј нҠ№мў…мҳҲкі г…Ӣг…Ӣ

- 2лӮҳмқҙл“Өл©ҙ мғқкё°лҠ” мҠөкҙҖ

- 3лҸҷл„Ө мһјлҜјмқҙ нҳјмӯҗлӮҙмӨҖ м–ҙлҠҗ лҢҖн•ҷмғқ

- 4лӢӨмқҙм•„лӘ¬л“ң м—…кі„ мҙҲ비мғҒ

- 5л¬ёнҷ”мҳҲмҲ кі„ pc충м—җкІҢ к°Җн•ҳлҠ” мқјм№Ё

- 6нҡҢмӮ¬л°Ҙмқҙ л„Ҳл¬ҙ л§ӣмһҲлҠ” мІҳмһҗ

- 7мҶҢлҰ¬ On) көӯнһҷ мӣҗнғ‘ лҜёлӢҲ 진 мӢ кіЎ к°ңм Җм”Ё л°ңн‘ң

- 8мұ…мһ„ м—ҶлҠ” мҫҢлқҪ к·јнҷ©

- 9м–өл§ҢмһҘмһҗл“Өмқҙ кіөнҶөм ҒмңјлЎң л§җн•ҳлҠ” лӢЁм җ

- 10мӮјлҘҳ м„ұмқё мӮ¬мқҙнҠё к°ҷл„Ө

- 1лё”лқјмқёл“ңм—җм„ң м¶”м •н•ң лҜјнқ¬м§„ мҝ лҚ°нғҖ кі„нҡҚ

- 2мҶҢмқҙнҳ„мқҙ лӮ 씬н•ң лӘёл§ӨлҘј мң м§Җн•ҳлҠ” мқҙмң .

- 3лё”лқјмқёл“ңм—җм„ң н•«н•ң м–ҙлҠҗ мҰқк¶Ңл§Ёмқҳ лҜјнқ¬м§„ 분м„қ кёҖ

- 4мӮ¬лӮҳ мӢңкө¬ л’·нғң мӣҖм§Ө мғқлҸҷк°җ

- 5лҘҙм„ёлқјн•Ң

- 6нӮ№лӢҲн…Ңмқј м•„мқҙмң

- 7нҺҢ) мҷҖмқҙн”„н•ңн…Ң м „лӮЁм№ң м–ҳкё° л“Јкі л№Ўм№ң нҳ•м•„.

- 8лҜёлӮҳ

- 9мӮ¬лӮҳ

- 10л°°мҡ° лҘҳмҲҳмҳҒ к·јнҷ©

(мЈј)мқёлІӨ

в–І